Generatiivinen tekoäly (GenAI) on mullistanut sisällön tuotannon, muuttaen tapojamme luoda ja kuluttaa tietoa. Tämä kehitys on kuitenkin asettanut luottamuksen koetukselle, kun ihmisten ja generatiivisen tekoälyn tuottamien sisältöjen erottaminen toisistaan on muuttunut yhä haastavammaksi. Kun GenAI kykenee tuottamaan ihmisenkaltaisesti tekstiä, kuvia, ääntä ja videoita, joutuu luottamuksemme kaikkeen näkemäämme ja kuulemaamme koetukselle. Tammikuussa 2024 alkaneessa LuovAIn!-hankkeessa pohditaan tekoälyn merkitystä luoville aloille myös tästä näkökulmasta.

Kirjoittajat: Sariseelia Sore & Markus Sjöberg

Generatiivisen tekoälyn mahdollisuudet

Generatiivinen tekoäly (GenAI) viittaa tekoälyjärjestelmiin, jotka kykenevät tuottamaan uutta sisältöä, kuten tekstiä, kuvia, ääntä ja videoita, olemassa olevan datan pohjalta. GenAI on mullistanut monia aloja, ja sen sovellukset ulottuvat laajalle – taiteesta ja viihteestä aina lääketieteellisiin innovaatioihin saakka. GenAI-teknologiat tarjoavat erityisesti luovilla aloilla valtavia mahdollisuuksia, sillä tekoäly voi toimia taiteilijan työkaluna laajentaen luovuuden rajoja sekä tehostaen suunnittelutyötä (Ali Elfa & Dawood 2023).

Deepfake-teknologian väärinkäytön vaikutuksia

GenAI:n kehittyminen on tuonut mukanaan haasteita, joista yksi on deepfake-teknologia. Deepfaket ovat tekoälyn luomaa synteettistä sisältöä, kuten kuvia tai videoita, jotka voivat näyttää aidolta mutta ovat manipuloituja. Vaikka deepfakeja hyödynnetään positiivisissa yhteyksissä, kuten viihteessä ja koulutuksessa, niitä käytetään myös väärin monin tavoin, joilla voi olla vakavia vaikutuksia ihmisiin ja yhteiskuntaan (Hancock & Bailenson 2021; Naitali ym. 2023). Deepfaket voivat vääristää poliittista keskustelua, heikentää luottamusta tiedotusvälineisiin, lietsoa väkivaltaa, horjuttaa talousmarkkinoita ja lisätä kyberturvallisuusriskejä (Mubarak ym. 2023).

Deepfake-teknologiaa on käytetty väärin monin tavoin, kuten disinformaation ja propagandan levittämiseen, maineen vahingoittamiseen sekä petoksiin. Esimerkiksi väärennetyt poliitikkojen puheet ja uutisvideot voivat vaikuttaa vaalituloksiin ja horjuttaa luottamusta poliittisiin instituutioihin (Naitali ym. 2023.) Myös yrityksille deepfakejen seuraukset voivat olla tuhoisia, kun manipuloituja kuvia tai videoita käytetään brändien maineen vahingoittamiseen (Fannin ym. 2022). Lisäksi deepfake-teknologia on helpottanut identiteettivarkauksia ja valeprofiilien luomista sosiaalisessa mediassa, mikä mahdollistaa taloudellisia huijauksia ja muuta vahingontekoa (Masood ym. 2023). Ali Elfa ja Dawood (2023) havaitsivat, että luottamus digitaalisiin sisältöihin horjuu, koska aitojen ja väärennettyjen materiaalien erottaminen on yhä vaikeampaa. Tämä on linjassa Vaccarin ja Chadwickin (2020) havaintojen kanssa, joiden mukaan altistuminen deepfakeille vähentää luottamusta uutisiin.

Deepfake-kuvien tunnistamisen testaus

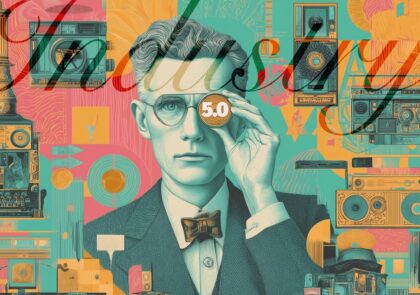

Masood ym. (2023) totesivat, että kehittyneen deepfake-teknologian vuoksi ihmissilmän on todella vaikea enää erottaa aitoa ja manipuloitua sisältöä. Tätä haluttiin testata omilla kuvilla ja järjestettiin kaksiosainen testi. Ensimmäisessä testissä osallistujille esitettiin seitsemän luontokuvaparia (kuva 1), joista toisessa kuvassa oli aito ja toisessa tekoälyn tuottama kuva. Osallistujien tehtävänä oli tunnistaa, kumpi kuvista oli aito.

Kuva 1. Testikuvaparit. Valokuvat: 1A, 2B, 3B, 4A, 5A, 6B, 7B. (Kuvat: Markus Sjöberg). Tekoälyllä luodut kuvat: 1B, 2A, 3A, 4B, 5B, 6A, 7A. (ohjelmistona käytetty Adobe Firefly/Stable Diffusion)

Testimme tulokset paljastivat, että vain hieman yli puolet osallistujista onnistui erottamaan aidon kuvan vastaavasta deepfake-kuvasta. Tämä osoittaa, että deepfake-kuvat ovat jo niin kehittyneitä, että niiden erottaminen aidoista on vaikeaa – jopa silloin, kun osallistujat keskittyvät tehtävään huolellisesti ja ovat tietoisia deepfake-kuvien olemassaolosta. Tulokset viittaavat siihen, että vaikka ihmisillä on jonkin verran kykyä havaita tekoälyn luomia kuvia, erot ovat usein niin hienovaraisia, että tunnistustarkkuus jää lähelle satunnaisen arvauksen tasoa.

Seitsemästä kuvaparista kolmessa tapauksessa enemmistö piti tekoälyllä tehtyä kuvaa aitona kuvana. Näissä tapauksissa aidoissa kuvissa oli joitain poikkeuksellisia elementtejä, kuten erikoisen muotoisia pilviä tai poikkeuksellinen ristiaallokko. Luontokuvaksen käytäntöjen näkökulmasta tulos kertoo kuitenkin haastavasta ongelmasta, sillä hyvissä luontokuvissa ikuistetaan usein jotain poikkeuksellista. Tästä syystä deepfaken mahdollisuuden olemassaolo voi heijastua myös niihin tapauksiin, joissa todellisuudessa on julkaistu aito luontokuva.

Kuvaparien tunnistamiseen kokeiltiin myös useita tekoälykuvien tunnistamiseen tarkoitettuja palveluita. Automaattiset tekoälykuvien tunnistusohjelmat pystyivät tunnistamaan vaihtelevalla menestyksellä osan tekoälykuvista. Yksikään ohjelmista ei kuitenkaan pystynyt tunnistamaan kaikkien kuvaparien tekoälykuvia. Tekoälykuvien tunnistaminen tekoälykuviksi olisi mahdollista käsityönä esimerkiksi kuvankäsittelyohjelmalla pikseleitä ja väritasoja tarkastelemalla, mutta todellisessa käytössä jokaisen valokuvan pikseleitä ei ole mahdollista tarkastella.

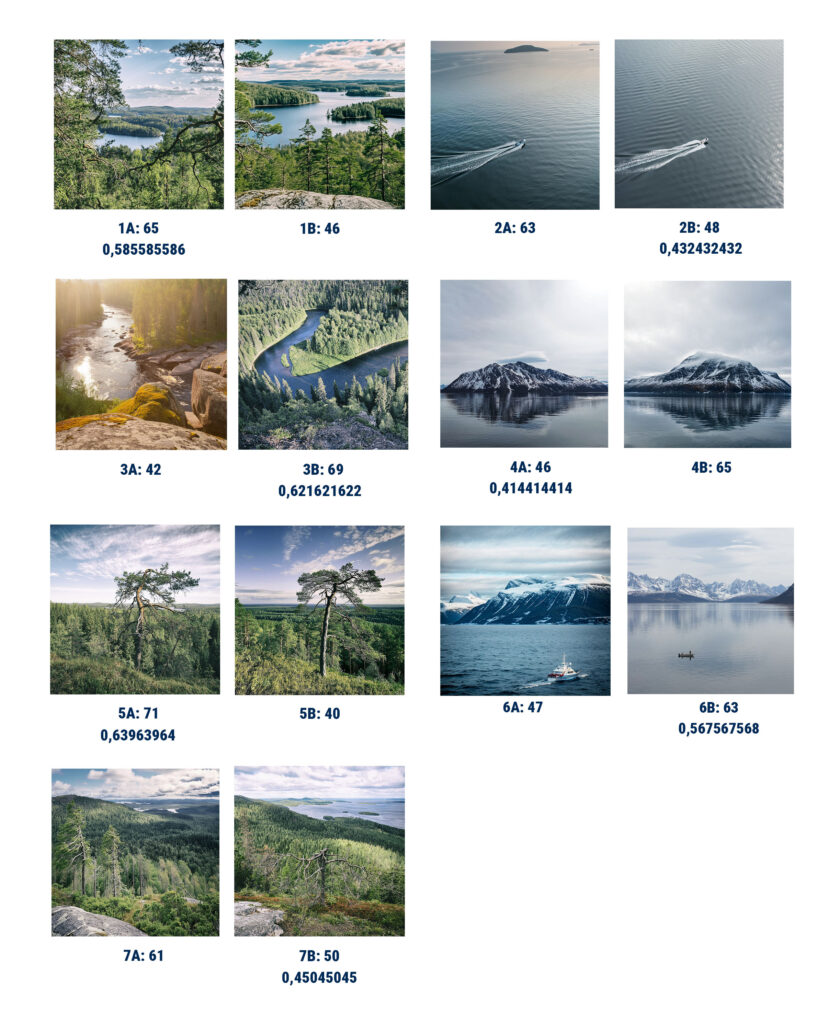

Toisen testin tavoitteena oli selvittää, kuinka hyvin ihmiset tunnistavat aidot kasvokuvat. Kokeessa esiteltiin osallistujille kokoelma, johon kuului 42 passikuvaa (kuva 2.), joista vain yksi oli oikean henkilön aito kuva. Passikuvat ovat erityisen kriittisiä tunnistamisen kannalta, koska ne liittyvät vahvasti virallisiin asiakirjoihin ja henkilöiden identiteettiin.

Kuva 2. Passikuvat. (Kuva D5: Markus Sjöberg, muut kuvat Adobe Firefly ja Stable Diffusion)

Vastaaja sai valita kuvista useamman kuin yhden vaihtoehdon. Oikean ihmisen löysi 6,4 prosenttia testin tehneistä ja 4,6 prosenttia valitsi pelkästään oikean vaihtoehdon. Aito kuva eroaa visuaalisesti selvästi tekoälykuvista, jos kuvia tarkastelee passikuvina. Kuvien luonnissa käytetyt tekoälymallit Adoben Firefly ja StabilityAIn kehittämän avoimen lähdekoodin Stable Diffusion eivät kyenneet tuottamaan passikuvien vaatimuksia täyttäviä kuvia.

Testi oli osallistujille haastava, sillä väärien vaihtoehtojen määrä oli huomattavasti suurempi kuin oikeiden. Testi havainnollistaa kuitenkin deepfake-teknologian aiheuttamaa riskiä esimerkiksi sosiaalisessa mediassa, sillä aidon henkilön erottaminen generoitujen kuvien joukosta on kasvava haaste. Tällä hetkellä bottien osuus ei kuitenkaan ole näin suuri yleisimmillä alustoilla; esimerkiksi on arvioitu, että jopa 15 % Twitterin (nykyisin X) käyttäjistä saattaa olla botteja (Varol ym. 2017). Kuvatuotannon näkökulmasta deepfake-profiilikuvien määrä voisi kuitenkin kasvaa enemmistöksi milloin tahansa, sillä GenAI-työkalut mahdollistavat satojen kasvokuvien luomisen vain muutamassa minuutissa.

Luottamuksen säilyttäminen digitaalisessa maailmassa

Perinteisesti valokuviin ja videoihin on voitu luottaa todisteina tapahtumista, mutta deepfake-teknologian kehittyminen on heikentänyt tätä luottamusta, erityisesti oikeudenkäyntien todistusaineistona. Toisaalta puhe manipulaatiosta ja sen merkityksestä on puhuttanut esimerkiksi luontokuvan kontekstissa jo vuosikymmenten ajan (Suonpää 2001). Valokuvan roolista todellisuuden kuvana on keskusteltu esimerkiksi siirryttäessä kemiallisesta valokuvasta digitaaliseen (Mitchell 2015; Seppänen 2014). Tässä mielessä deepfake-ilmiötä voidaan pitää digitaalisen manipulaation saralla jatkumona, joka on saanut tekoälytyökalujen myötä entistä monipuolisempia, helppokäyttöisempiä ja uskottavampia muotoja. Kuvien ja videoiden lisäksi myös äänen kloonaus voi merkittävästi murentaa yleistä luottamusta, tarjoten rikollisille mahdollisuuden manipuloida niin liiketoimia kuin yksityisiä puheluita. Äänen kloonauksen yhdistäminen deepfake-teknologiaan luo erityisen haasteen näiden manipulointien tunnistamisessa. (Masood ym. 2023.)

Luottamuksen säilyttäminen digitaalisessa maailmassa edellyttää monipuolisia toimia, joihin kuuluu tehokkaiden järjestelmien kehittäminen deepfake-sisällön tunnistamiseen. Nykyiset menetelmät hyödyntävät useita lähestymistapoja, kuten visuaalisten virheiden, esimerkiksi ihonvärin muutosten, ja biologisten signaalien, kuten silmien liikkeiden, analysointia. Deepfake-videoissa silmien liikkeet ja räpyttely voivat olla poikkeavia tai puuttua kokonaan, ja kasvonpiirteet tai ihon tekstuurit saattavat näyttää epäluonnollisilta. Juuri tällaiset yksityiskohdat voivat antaa tärkeitä vihjeitä manipulaation tunnistamiseen. (Masood ym. 2023; Naitali ym. 2023.)

Kun otetaan huomioon, että deepfake-videoille altistuminen voi aiheuttaa pysyvää haittaa, kuten Fannin ym. (2022) osoittivat, on selvää, että pelkkä tunnistus ei riitä väärennösten torjunnassa. Koska tunnistusmenetelmät ja deepfakejen tuotanto ovat jatkuvassa kilpajuoksussa (Masood ym. 2023), tarvitaan kokonaisvaltaisempia ratkaisuja Olisi suuri virhe, kuten Vaccari ja Chadwick (2020) korostavat, pitää väärennöksiä pelkkinä teknologisina haasteina. Psykologisiin prosesseihin perustuvat menetelmät, kuten epäilyn lisääminen, ovat yksi keino lieventää altistumisen vaikutuksia (Fannin ym. 2022). Lisäksi Mubarak ym. (2023) korostavat, että teknisten ratkaisujen ohella yleisön tietoisuuden lisääminen ja lainsäädännön kehittäminen ovat välttämättömiä keinoja deepfakejen tehokkaaseen torjumiseen.

Yksi keskeisimmistä muutostarpeista liittyy kuvan, etenkin valokuvan indeksikaalisen luonteen uudelleenmäärittelyyn. Vaikka tekoälyllä luodut kuvat voivat näyttää ulkoisesti valokuvilta, ne eivät ole valokuvan tavoin tietyssä hetkessä ja paikassa tallennettua valoa (vrt. Seppänen 2014). Valokuvakaan ei silti todellisuuteen sitoutuneesta luonteestaan huolimatta ole sellaisenaan todiste. Jokainen kuva on aina rajattu, sommiteltu ja valittu hetki, vaikka kuvaa ei olisikaan muokattu. Valokuva on siis ennemmin kertomus kuin todiste. Kuvaan liittyvän luottamuksen näkökulmasta deepfaken aiheuttama uhka voi jopa parantaa tervettä suhtautumista kuvaan. Koska jokainen kuva voi periaatteessa olla generoitu, tulee visuaaliseen sisältöön suhtautua kertomuksena, jonka todenperäisyys tulee pyrkiä selvittämään myös muilla tavoin, kuin pelkästään kuvan sisältöä tarkastelemalla. Vain yhdistämällä tekniset, psykologiset ja yhteiskunnalliset keinot voidaan vastata deepfake-teknologian haasteisiin ja suojella yhteiskuntaa sen haitallisilta vaikutuksilta.

Lähteet

Ali Elfa, M. A. A. & Dawood, M. E. T. 2023. Using artificial intelligence for enhancing human creativity. Journal of Art, Design and Music. 2(2), 3. Viitattu 15.11.2024. Saatavissa https://doi.org/10.55554/2785-9649.1017

Fannin, J., Schlager, T. & Johar, G. 2022. Don’t trust what you see: The consequences of deepfake videos for consumer evaluation of firms and their representatives. Advances in Consumer Research. 50, 187-189.

Jäntti, S., Saresma T., Sääskilahti N. ja Vallius, A. 2014 Rajatut maisemat. Teoksessa Saresma, T. & Jäntti, S. (toim.) Maisemassa. Sukupuoli suomalaisuuden kuvastoissa. Jyväskylä: Jyväskylän yliopisto. Nykykulttuurin tutkimuskeskuksen julkaisuja 115. 9–25.

LuovAIn!. 2024. Tekoäly luovan ja kulttuurialan ekosysteemissä – LuovAIn! Viitattu 6.9.2024. Saatavissa https://lab.fi/fi/projekti/tekoaly-luovan-ja-kulttuurialan-ekosysteemissa-luovain

Masood, M., Nawaz, M., Malik, K. M., Javed, A., Irtaza, A. & Malik, H. 2023. Deepfakes generation and detection: State-of-the-art, open challenges, countermeasures, and way forward. Applied intelligence. 53 (4), 3974-4026. Viitattu 15.11.2024. Saatavissa https://doi.org/10.1007/s10489-022-03766-z

Mitchell, W.J.T. 2015. Image Science. Chicago: The University of Chicago Press.

Mubarak, R., Alsboui, T., Alshaikh, O., Inuwa-Dute, I., Khan, S. & Parkinson, S. 2023. A survey on the detection and impacts of deepfakes in visual, audio, and textual formats. IEEE Access. 11. Viitattu 15.11.2024. Saatavissa https://doi.org/10.1109/ACCESS.2023.3344653

Naitali, A., Ridouani, M., Salahdine, F. & Kaabouch, N. 2023. Deepfake attacks: Generation, detection, datasets, challenges, and research directions. Computers. 12 (10), 216. Viitattu 15.11.2024. Saatavissa https://doi.org/10.3390/computers12100216

Hancock, J. T. & Bailenson, J. N. 2021. The social impact of deepfakes. Cyberpsychology, behavior, and social networking. 24 (3), 149-152. Viitattu 15.11.2024. Saatavissa https://doi.org/10.1089/cyber.2021.29208.jth

Seppänen, J. 2014. Levoton valokuva. Tampere: Vastapaino.

Suonpää, J. 2001. Luontokuvan totuuden hetki : keskustelua aitoudesta. Helsinki: Suomen valokuvataiteen museo.

Vaccari, C. & Chadwick, A. 2020. Deepfakes and disinformation: Exploring the impact of synthetic political video on deception, uncertainty, and trust in news. Social Media + Society. 6 (1). Viitattu 15.11.2024. Saatavissa https://doi.org/10.1177/2056305120903408

Varol, O., Ferrara, E., Davis, C. A., Menczer, F., & Flammini, A. 2017. Online Human-Bot Interactions: Detection, Estimation, and Characterization. Proceedings of the International AAAI Conference on Web and Social Media (ICWSM).

Kirjoittajat

Sariseelia Sore työskentelee LAB-ammattikorkeakoulussa lehtorina ja koordinaattorina liiketoiminnan digitaaliset ratkaisut (YAMK) koulutuksessa. Viime vuosina hän on johtanut ja osallistunut useisiin yritysten digitaaliseen transformaatioon liittyviin kehitysprojekteihin. Tällä hetkellä hän toimii asiantuntijana Tekoäly luovan ja kulttuurialan ekosysteemissä – LuovAIn! -hankkeessa.

Markus Sjöberg työskentelee Tampereen yliopistossa Tekoäly luovan ja kulttuurialan ekosysteemissä – LuovAIn! -hankkeen tutkijana. Hänen tutkimuksensa keskittyy generatiivisten työkalujen käyttöön luovalla alalla. Sjöberg tekee myös väitöskirjaa suomalaisista luontokuvista digitaalisessa kulttuurissa.

Artikkelikuva: https://pxhere.com/fi/photo/480 (CC0)

Viittausohje

Sore, S. & Sjöberg, M. 2024. Luottamus koetuksella generatiivisen tekoälyn aikakaudella. Viitattu pvm. Saatavissa https://www.labopen.fi/lab-rdi-journal/luottamus-koetuksella-generatiivisen-tekoalyn-aikakaudella/